AI 모델은 데이터가 많을수록 잘 배웁니다.

하지만 현실에서 “라벨 데이터”는 늘 부족하죠. 🥲

저도 현업에서 가장 많이 들었던 말이 “데이터 라벨링 예산이 없다”, “데이터 수집은 다음 분기에나 가능하다”였습니다.

그래서 오늘은 적은 데이터로도 모델을 똑똑하게 만드는 방법을 알려드리려 합니다.

데이터 부족은 왜 문제일까?

딥러닝 모델은 수천, 수만 장의 라벨 데이터를 먹여야 제대로 학습됩니다.

하지만 실무에서는

- 라벨링 비용이 너무 비싸거나

- 데이터가 극도로 희귀하거나

- 빠른 프로토타입이 필요한 상황

같은 이유로 충분한 데이터를 확보하기 어렵습니다.

저도 한 번은 CCTV에서 휠체어만 인식하는 모델을 만들 때, 라벨링된 휠체어 데이터는 500장밖에 없었습니다.

그럼에도 불구하고 모델을 돌려야 했죠.

이런 상황에서 Few-Shot Learning, Transfer Learning 같은 접근법이 구세주가 됩니다.

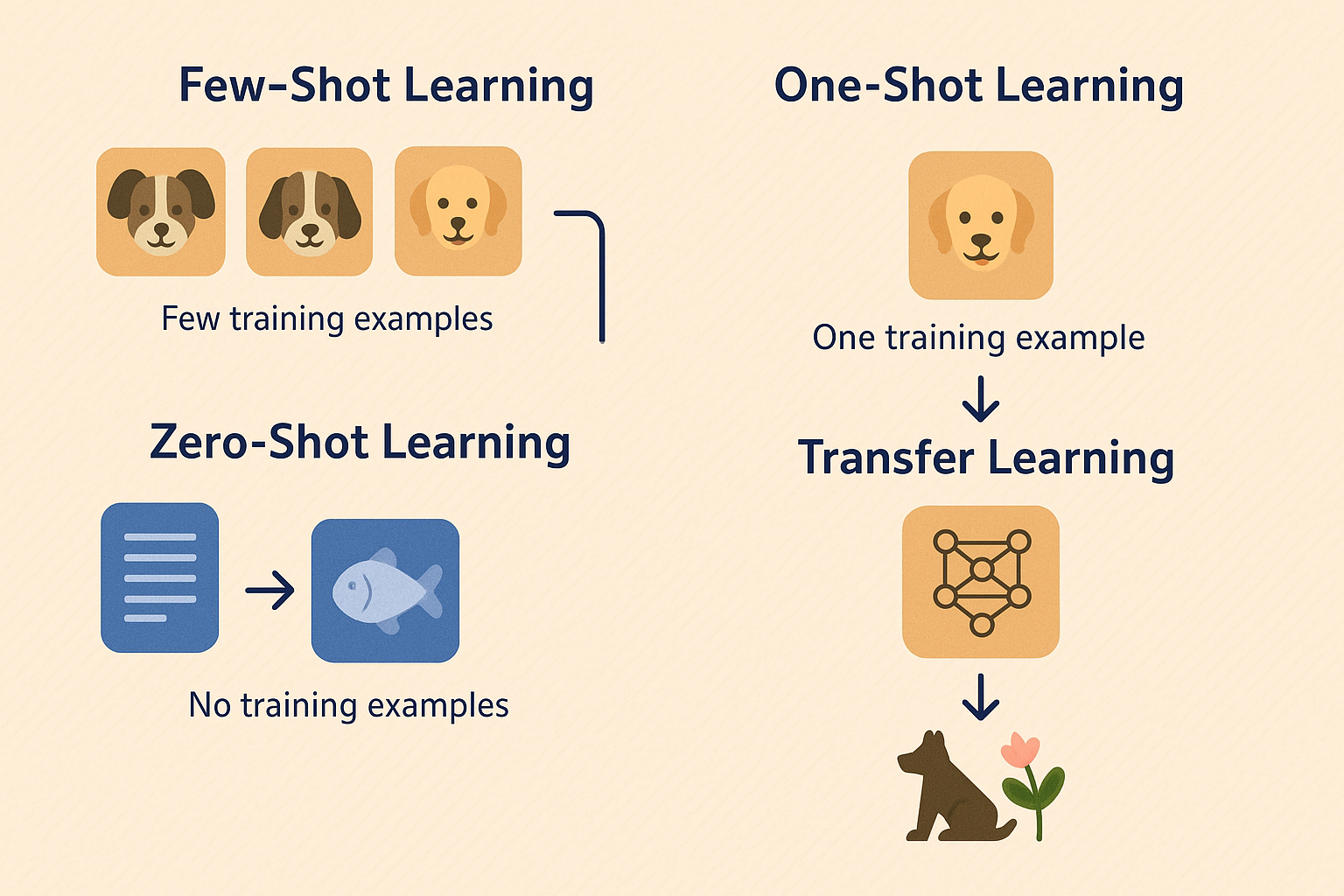

Few-Shot / One-Shot / Zero-Shot Learning

Few-Shot Learning은 모델이 소수의 예시만 보고 학습하는 방법입니다.

예를 들어 GPT 프롬프트에 예시 몇 개만 넣어주고 원하는 형태로 답을 생성하게 하는 것이 바로 Few-Shot입니다.

- One-Shot Learning : 예시 1개로 학습

- Few-Shot Learning : 예시 몇 개(10개 이내)로 학습

- Zero-Shot Learning : 예시 없이도 일반화

💡 실생활 예시

- 얼굴 인식 시스템 : 특정 사람 얼굴 한두 장만 학습해도 인식

- GPT 프롬프트 : "아래처럼 요약해줘" + 예시 2~3개 → 원하는 포맷으로 답변 생성

- 이미지 분류 : 10장 미만의 샘플로 새로운 클래스 학습

제가 해본 One-Shot 사례는 반려견 종 분류 모델입니다.

새로운 강아지 종을 추가할 때 데이터가 3장밖에 없었는데, 기존 모델의 임베딩 공간만 업데이트해도 꽤 잘 맞추더군요.

Transfer Learning – 사전학습의 힘

Transfer Learning은 이미 학습된 모델을 가져와 내 문제에 맞게 다시 학습(Fine-tuning)하는 방법입니다.

마치 영어 잘하는 친구에게 “이제부터 불어 공부 좀 같이 하자”라고 하는 느낌입니다.

- Pretrained 모델 불러오기 → ResNet, EfficientNet, BERT 등

- 마지막 레이어만 교체 → 내 데이터에 맞는 클래스 수로 변경

- 짧게 Fine-tuning → 적은 데이터로도 빠른 수렴

💡 실무 활용

- ImageNet으로 학습된 모델 → 공장 불량 탐지 모델로 전환

- 대규모 텍스트로 학습된 BERT → 의료 논문 분류 모델로 전환

저는 공장 불량 탐지 프로젝트에서 Transfer Learning을 적극 활용했습니다.

처음부터 모델을 학습시키면 수십만 장의 데이터가 필요했지만,

사전학습된 모델을 가져와 Fine-tuning하니 1만 장 데이터로도 높은 성능을 얻을 수 있었어요.

Meta Learning – 학습하는 법을 학습하기

Meta Learning은 모델이 “배우는 방법” 자체를 학습하는 방식입니다.

새로운 데이터셋이 들어와도 빠르게 적응하도록 학습시키는 거죠.

대표적인 알고리즘으로 MAML(Model-Agnostic Meta-Learning)이 있습니다.

이 방식은 의료 AI처럼 클래스가 자주 바뀌는 상황에서 매우 유용합니다.

저도 의료 영상에서 새로운 병변 클래스가 추가될 때,

Meta Learning을 적용해 모델이 빠르게 적응하도록 실험한 적이 있습니다.

데이터 부족 해결 전략 한눈에 정리

- Few-Shot/One-Shot : 소량의 예시로 새로운 태스크 해결

- Zero-Shot : 예시 없이도 일반화된 답 생성

- Transfer Learning : 사전학습 모델을 가져와 내 데이터로 Fine-tuning

- Meta Learning : 새로운 데이터에 빠르게 적응하는 학습법 학습

📌 스토리로 다시 정리

데이터가 부족하다고 프로젝트를 포기할 필요는 없습니다.

Few-Shot과 Transfer Learning은 제가 현업에서 가장 많이 쓴 전략입니다.

라벨링 비용을 줄이고도 빠른 프로토타입을 만들 수 있고,

초기 PoC 단계에서 의사결정자 설득에도 큰 도움이 됩니다.

결론 – 데이터 부족은 더 이상 변명이 아니다

오늘은 데이터가 부족할 때 쓰는 Few-Shot / Transfer Learning과

Meta Learning, Zero-Shot Learning까지 살펴봤습니다.

이 전략들을 잘 활용하면 라벨이 적어도 강력한 모델을 만들 수 있습니다. 🔥

다음 편에서는 Domain Adaptation, Continual Learning을 다뤄

환경이 달라져도 끄떡없는 AI 모델 만드는 법을 이야기하겠습니다.

여러분은 Few-Shot이나 Transfer Learning을 실무에서 써본 경험이 있나요?

댓글로 공유해 주시면 다음 글에서 함께 소개할 수도 있어요.👇

다음편은 아래에 있습니다!

https://machineindeep.tistory.com/115

[3편] Domain Adaptation · Generalization · Continual Learning – 환경이 바뀌어도 끄떡없는 AI 만들기

AI 모델은 한 번 학습하면 끝일까요?아쉽게도 현실은 그렇지 않습니다. 😅저도 처음 만든 CCTV 이상행동 탐지 모델이 맑은 날에는 잘 작동하다가,비 오는 날 갑자기 성능이 반토막 난 경험이 있습

machineindeep.tistory.com

'ML | DL > 딥러닝의 여러가지 학습 방법론' 카테고리의 다른 글

| [6편] Active Learning · Data Augmentation · Synthetic Data – 데이터 효율 극대화 전략 (3) | 2025.09.18 |

|---|---|

| [5편] 강화학습 & RLHF – 알파고부터 ChatGPT까지, 스스로 배우는 AI의 비밀 (1) | 2025.09.18 |

| [4편] Multi-Task · Multi-Label · Curriculum Learning – 하나의 모델로 더 똑똑하게 학습시키기 (1) | 2025.09.18 |

| [3편] Domain Adaptation · Generalization · Continual Learning – 환경이 바뀌어도 끄떡없는 AI (1) | 2025.09.18 |

| [1편] 지도학습 vs 비지도학습 – 헷갈린다면 이 글 하나로 끝! (1) | 2025.09.18 |