반응형

FastVLM: Efficient Vision Encoding for Vision Language Models

해당 논문을 요약한 내용입니다.

최근 Vision-Language Model(VLM)은 텍스트가 풍부한 이미지를 이해해야 하는 다양한 작업에서 뛰어난 성능을 보이고 있습니다. 하지만 고해상도 이미지를 처리하려면 Vision Encoder의 연산량이 급격히 증가하고, Time-To-First-Token(TTFT)이 느려지는 문제점이 있습니다. 이번 논문은 이 문제를 해결하기 위해 FastVLM과 FastViTHD라는 새로운 접근법을 제안합니다.

연구 배경 및 문제 정의

- 기존 문제:

- ViT-L/14 같은 대형 Vision Transformer는 해상도를 올리면 토큰 수가 급격히 증가 → 연산량 폭증

- 인코딩 지연(latency)이 커지고, VLM 응답속도가 느려짐

- 연구 목표:

- 고해상도 입력에서도 **빠른 응답 속도(TTFT)**와 높은 성능을 동시에 달성

- 추가적인 토큰 가지치기(pruning) 없이 단순한 설계로 최적의 해상도-토큰 수-성능 균형을 찾기

핵심 아이디어: FastVLM & FastViTHD

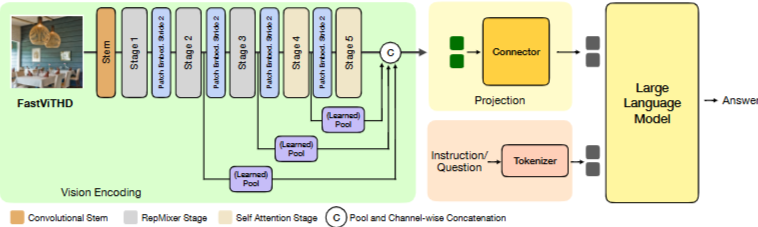

FastViTHD: 새로운 하이브리드 비전 인코더

- 구조:

- 5단계 단계적 다운샘플링 + RepMixer 블록(초기단) + Self-Attention 블록(후반단)

- Self-Attention은 32배 다운샘플된 텐서에서 수행 → 연산량 대폭 절감

- 효과:

- 고해상도 이미지에서도 토큰 수를 4~16배 줄임

- 인코딩 속도 ↑, 메모리 사용량 ↓

- 설계 단순화 (추가 토큰 가지치기 필요 없음)

FastVLM: 전체 VLM 프레임워크

- LLaVA-1.5 설정에서 TTFT 3.2배 향상

- LLaVA-OneVision 대비:

- 85배 빠른 TTFT

- 3.4배 작은 Vision Encoder

- 주요 벤치마크(SeedBench, DocVQA 등)에서 더 높은 점수

주요 방법론 & 실험

- 하이브리드 백본 우수성 증명

- Conv + Transformer 조합이 ViT 단독보다 고해상도 처리에서 효율적

- Multi-Scale Features 활용 → 성능 추가 향상

- AvgPooling vs Depthwise Convolution 비교 → Depthwise Convolution 우세

- 효율성-정확도 트레이드오프 분석

- 다양한 LLM 크기(0.5B, 1.5B, 7B) & 해상도 조합으로 Pareto-Optimal 커브 작성

- FastViTHD가 FastViT보다 평균 2.5점 ↑, 최대 3배 빠른 목표 성능 달성

- 동적 해상도 vs 직접 해상도 조정

- AnyRes 방식보다 직접 해상도 조정이 대부분의 경우 더 좋은 정확도-지연 시간 균형

결과 요약

| 모델 | TTFT 속도 | 파라미터 수 | 주요 벤치마크 성능 |

| ViT-L/14 | 느림 | 매우 큼 | 기준선 |

| FastViT | 개선됨 | 중간 | 향상 |

| FastViTHD | 최고속 | 2.4x 작음 | SeedBench, MMMU, DocVQA 모두 우수 |

- 평균 성능 유지 or 향상 + 최대 85배 TTFT 개선

- 더 작은 모델로도 최신 SOTA 모델(MM1, Cambrian-1)과 대등 또는 그 이상 성능

자세한 논문은 아래서

반응형

'ML | DL > 딥러닝 논문' 카테고리의 다른 글

| 5분 컷 논문 리뷰: VLM-R1 – R1 스타일 RL로 시각적 추론 강화하기 (1) | 2025.09.15 |

|---|---|

| 5분 컷 논문 리뷰: Are VLMs Ready for Autonomous Driving? (1) | 2025.09.15 |

| PBNS(Physically Based Neural Simulation for Unsupervised Outfit Pose Space Deformation) 논문 리뷰 (0) | 2024.04.11 |

| CLIP(Contrastive Language-Image Pre-Training) 논문 리뷰 (0) | 2024.04.11 |

| BlazePose: On-device Real-time Body Pose tracking 리뷰 (0) | 2022.03.18 |