반응형

VLM-R1: A Stable and Generalizable R1-style Large Vision-Language Model

논문의 내용을 요약한 것 입니다.

연구 배경 & 목표

최근 DeepSeek-R1 등 규칙 기반 보상(rule-based reward)을 활용한 RL이

LLM의 추론 능력을 극적으로 향상시킨 사례가 나오면서,

“이걸 VLM에도 적용하면 시각적 추론도 좋아질까?”라는 질문이 생겼습니다.

논문 VLM-R1은 이 질문에 답하기 위해

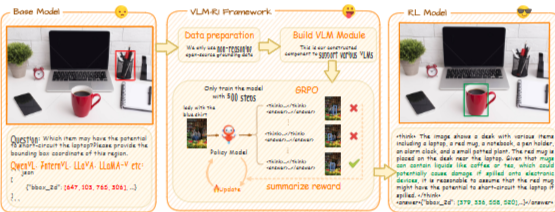

R1-style RL을 Vision-Language Model(VLM)에 적용하는 전용 프레임워크를 제안하고,

REC(Referring Expression Comprehension)와 OVD(Open-Vocabulary Object Detection) 태스크에서

RL의 효과를 체계적으로 검증했습니다.

VLM-R1 프레임워크 설계

- Open-R1 기반 모듈형 설계 → 다양한 VLM (QwenVL, InternVL 등) 지원

- 핵심 구성 요소

- grpo_jsonl.py : 데이터 전처리 + 커스텀 보상 함수 정의

- grpo_trainer.py : GRPO 훈련 관리, 후보 응답 샘플링 → 보상 평가 → 파라미터 업데이트

- 모델 추상화 계층 → 입력 포맷팅, 모델 초기화, LoRA fine-tuning, vision tower freeze 등 통합 관리

핵심 방법론: GRPO (Group Relative Policy Optimization)

GRPO는 PPO에서 critic 모델을 제거하고,

같은 질문에 대해 샘플링한 후보 응답 그룹을 직접 비교해 상대 이점을 추정합니다.

이를 사용해 정책을 업데이트하며, KL 페널티로 기준 정책과의 과도한 괴리를 방지합니다.

보상 함수는 정확도 보상 + 형식 보상 두 가지로 구성됩니다.

보상 설계

- REC (Referring Expression Comprehension)

- 정확도 보상: IoU 기반 GT 박스와 예측 박스 일치도

- 형식 보상: <answer> 태그 내 JSON 스타일 형식 준수 여부

- OVD (Open-Vocabulary Object Detection)

- 정확도 보상: mAP + 과도 예측 패널티 sovds_{ovd}

- 형식 보상: markdown-style JSON 응답 형식 준수

주요 실험 결과

REC (Refcoco/+/g & LISA-Grounding)

- RL 모델은 SFT 대비 일관된 성능 향상

- 특히 OOD (LISA-Grounding)에서 +8.32%p ↑

- SFT 모델은 학습 후반 성능 하락 ↘, RL 모델은 안정적 성능 유지 ↗

OVD (COCOfiltered & OVDEval)

- mAP +2.6%p, Precision +4.42%p, Recall +4.33%p

- 복잡한 reasoning 태스크 (Position, Relationship, Negation)에서 대폭 개선 (+9.2, +8.4, +3.3점)

주요 통찰 (Insights)

- Reward Hacking 방지

- 기존 mAP 보상 → 과도 예측 유도 → 보상 해킹 발생

- odLength 패널티 추가 → “OD aha moment” (객체 존재 여부 → 박스 예측 순서 학습) 유도

- 데이터 품질 중요성

- 단순 COCO보다 D3 (의미론적으로 더 복잡한 쿼리)로 학습 시 성능 ↑

- RL은 도전적인 데이터에서 더 강한 추론 체인 학습

- 모델 스케일 효과

- 3B → 7B → 32B로 갈수록 RL의 효과 커짐

- 대형 모델일수록 RL이 잠재 추론 능력을 더 잘 끌어냄

비판점 & 한계

- 보상 함수 설계 의존성

- 보상이 모델 행동을 과도하게 제한할 경우 학습 편향 가능

- 비용 문제

- 다중 후보 응답 샘플링 → RL 학습 비용 ↑

- 범용성 검증 한계

- REC/OVD 중심 실험 → 다른 시각-언어 태스크에도 동일한 효과가 나타날지는 추가 연구 필요

- 보상 신뢰도

- 형식 보상 등은 규칙 기반이라 실제 semantic correctness를 완전히 보장하지 않음

앞으로의 연구 방향

- 다양한 태스크 확장

- VQA, ChartQA, VideoQA 등 복잡한 reasoning 태스크에도 RL 적용

- 멀티모달 보상 함수

- 텍스트+비전+추론 일관성을 모두 반영한 복합 보상 설계

- 효율적인 샘플링 전략

- 학습 비용을 줄이는 후보 응답 선택/랭킹 알고리즘 연구

- Human-in-the-Loop RLHF

- 사람이 직접 고른 응답으로 reward signal 보강 → 더 안정적 학습 가능

- 스케일업 연구

- 수십B 이상의 초대형 VLM에서 RL 성능 향상 검증

한줄 코멘트

VLM-R1은 “시각적 R1”을 현실화한 첫 시도

RL이 단순 성능 향상을 넘어 시각적 reasoning 패턴을 재편성할 수 있음을 보여줌.

앞으로는 보상 설계 + 데이터 품질 + 모델 스케일의 조합이

VLM 추론 능력 진화를 가속할 핵심 열쇠가 될 것.

더욱 자세한 논문내용은 아래에서

반응형

'ML | DL > 딥러닝 논문' 카테고리의 다른 글

| 5분 컷 논문 리뷰: 왜 언어 모델은 환각을 일으킬까? (2) | 2025.09.15 |

|---|---|

| 5분 컷 논문 리뷰: Easy Dataset – 비정형 문서를 LLM 학습 데이터로 바꾸는 통합 파이프라인 (1) | 2025.09.15 |

| 5분 컷 논문 리뷰: Are VLMs Ready for Autonomous Driving? (1) | 2025.09.15 |

| 5분 컷 논문 리뷰: FastVLM으로 VLM 85배 빠르게 만들기 (1) | 2025.09.15 |

| PBNS(Physically Based Neural Simulation for Unsupervised Outfit Pose Space Deformation) 논문 리뷰 (0) | 2024.04.11 |